Mein Fazit nach 3 Tagen KI-Deep Dive

Begeistert und ernüchtert zugleich – so ist mein „Zustand“ nach drei Tagen Intensivseminar zum Thema KI in der PR. Text, Bild und Video haben wir betrachtet, die neuesten Entwicklungen und Möglichkeiten unter die Lupe genommen. Klar für mich ist: Den einen richtigen Weg gibt es nicht. Vieles ist noch trial & error, einiges funktioniert schon ganz gut. Und: Ich muss stetig am Ball bleiben.

Meine Learnings zum Thema Texten mit KI sind im Wesentlichen dreierlei.

Der richtige Prompt für bessere Ergebnisse

Es funktioniert schon ganz gut, sofern der Prompt gut gemacht ist und die KI nicht anfängt, doch zu halluzinieren (was bei fehlendem Datenbestand leider schon mal der Fall sein kann). Was ist eigentlich aber ein gut gemachter Prompt? Wichtig ist auf alle Fälle eine klare Strukturierung in zum Beispiel Rolle, Kontext, Aufgabe, Stil und Struktur. Damit die KI Anfang und Ende dieser Bausteine erkennt, ist eine Markdown-Syntax sinnvoll, beispielsweise für den Teil Rolle:

<role>

Du bist ein exzellenter Social-Media-Experte xxxx.

</role>

….und dann geht es immer munter weiter mit den anderen Bausteinen deines perfekten Prompts. Wichtig ist, dass du „Rolle“ von „Aufgabe“ sauber inhaltlich trennst. Auch das Ende muss stimmen, also der Abbinder oder der Conversation Starter. Es ist gleich, wie du es nennst, nur muss es auch wieder in dem Format <xxx> / </xxx> erfolgen. Mit diesem Abbinder definierst du was die KI dich jetzt fragen oder tun soll. Typischerweise sind es Aufforderungen wie „Antwort mit Quelle“ oder „Frage mich nach dem Thema“.

Eigentlich gar nicht so schwer. Und natürlich ist es immer wichtig, die Prompt-Ergebnisse zu bewerten. Hat die KI sich auf Daten gestützt oder doch frei hinzuerfunden. Ein Quercheck ist sinnvoll und wichtig.

Willst du dir über ChatGPT längere Texte zusammenfassen lassen, ist es besser, dieses nach und nach häppchenweise zu tun. Gibst du direkt beispielsweise einen 50-seitigen Text ein bzw. lädst ein langes pdf hoch, kann es zu Auslassungen und Ungenauigkeiten kommen. Denn für die KI ist der Anfang und das Ende eines Schriftstücks immer prioritär.

Prompt Engineering in der Praxis

Prompt Chaining ist eine super Sache, wenn man schnell mehrere Texte produzieren will, die aufeinander aufbauen. Statt eines einzigen, sehr komplexen Prompts zerlegt man eine Aufgabe in kleinere, aufeinander aufbauende Schritte. Für den Krisenkommunikationsfall kann man beispielsweise folgendes Prompt Chaining einrichten:

- Quelle für Prompt 1 (Beschreibung des Krisenfalls)

- Prompt 1 (Erstellung eines Fragenkatalogs für kritische Journalistenfragen)

- Prompt 2 (Generierung von Antworten auf diesen Fragenkatalog)

- Prompt 3 (Erstellung Presse-Statement auf Basis der Antworten bzw. des Fragen-/Antwortkatalogs)

- Prompt 4 (Erstellung einer ausführlicheren Pressemitteilung)

Am besten ist es, sich für jeden Prompt einen GPT zu programmieren. Mit dem @-Zeichen ist es dann im Chat-Fenster möglich, die einzelnen Prompts nacheinander kettenartig ablaufen zu lassen. Klingt kompliziert? Na ja, etwas Eindenken in die Materie erfordert es, ist aber machbar.

Im Krisenfall kann man so bereits vorbereitete Prozessketten, Mustertexte, Checklisten geschickt miteinander verknüpfen. Natürlich gilt aber auch hier: Das Ergebnis muss immer noch geprüft und oft noch noch überarbeitet werden – im besten Fall aber nicht mehr viel. Und ebenso gilt: Die Beschreibung des Krisenfalls muss als Basisdokument alle wesentlichen Fakten enthalten.

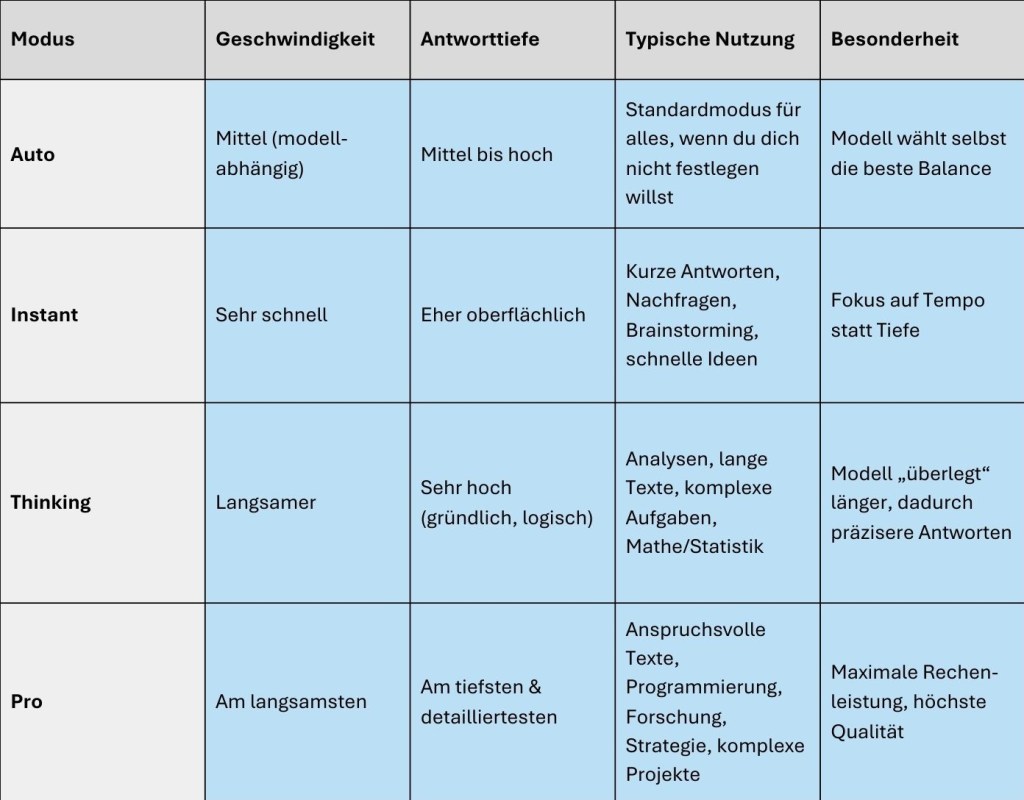

Welcher KI-Modus für welche Aufgabe

Standardmäßig ist bei deinem ChatGPT Plus (dem Router) die neue Oberfläche ChatGPT 5 „eingestellt“ mit der „Auto“ Funktion. Das ist der Standardmodus, bei dem das Modell selbst entscheidet, welcher Stil/Modus am besten passt. Die Erfahrung zeigt, dass die Technologie aber nicht immer passend auswählt. Hast du beispielsweise eine komplexe Fragestellung mit vielen Schritten oder mathematische Aufgaben, dann ist der Thinking Modus (Deep Research) wahrscheinlich geeigneter. In dem Plus-Abo bietet ChatGPT folgende Modi an:

- Auto – der Standardmodus

- Instant – schnelle Antworten, weniger tiefgreifend, für schnelle Nachfragen und einfache Aufgaben

- Thinking – Deep Research Modus: Das Modell hat mehr Zeit zum Überlegen. Die Antworten sind fundierter, detaillierter und logischer aufgebaut. „Thinking“ eignet sich für komplexe Fragestellungen, Analysen, strukturierte Texte, arbeitet aber deutlich langsamer.

Dann kannst du noch „Pro“ wählen, brauchst dafür aber ein Upgrade. Damit hast du wohl die beste Qualität. Ich selbst habe es noch nicht getestet.

Vor allem bei tiefgreifenden Aufgaben zeigt der „Thinking“-Modus seine Stärke – dank LRM-Technologie (Large Reasoning Model). Diese ermöglicht logisches, mehrschrittiges Denken und komplexe Problemlösung. Allerdings benötigt dieser Modus deutlich mehr Energie – ein Faktor, der auch im Sinne der Nachhaltigkeit berücksichtigt werden sollte. Für konkrete Textaufgaben, wie die Erstellung eines Social-Media-Posts oder eines Newslettertextes, ist meist der Modi „Auto“ ausreichend.

Fazit: KI ist Werkzeug, kein Wundermittel

Nach drei Tagen intensiver Auseinandersetzung mit KI in der PR bleibt für mich:

- KI kann die Arbeit deutlich erleichtern – aber sie ersetzt keine journalistische Sorgfalt.

- Gute Prompts sind entscheidend – Struktur, Klarheit und Bewertung sind Pflicht.

- Die Technologie entwickelt sich rasant – wer mithalten will, muss am Ball bleiben.

- Es ist keine Magie – vieles funktioniert, manches (noch) nicht. Trial & Error gehört dazu.

KI ist ein mächtiges Werkzeug, aber kein Ersatz für Expertise. Wer sie gezielt einsetzt, kann Prozesse beschleunigen, Ideen generieren und Texte effizienter produzieren – muss aber stets die Kontrolle behalten. Und manchmal hilft eben nur eines: selbst denken.